L’assemblaggio di un personal computer a partire da componenti discreti rappresenta un esercizio altamente formativo, che trascende la mera operazione tecnica per configurarsi come un processo di appropriazione critica delle logiche sottese all’architettura dei sistemi informatici contemporanei. Questa pratica, che implica un’interazione diretta con l’hardware e una pianificazione coerente delle risorse, consente non solo un controllo puntuale sul rapporto costo-prestazioni, ma anche una profonda comprensione dei meccanismi di integrazione e interoperabilità tra moduli computazionali.

Ben oltre il profilo amatoriale, l’autoassemblaggio di un PC assume un significato progettuale strategico nei contesti in cui l’ottimizzazione delle risorse computazionali deve essere tarata su casi d’uso altamente specifici, come il calcolo parallelo, la modellazione tridimensionale, la simulazione fisica o la produzione audiovisiva ad alta definizione. La fase preliminare di progettazione, pertanto, richiede un’analisi funzionale dei carichi di lavoro previsti e della scalabilità desiderata, nonché la capacità di valutare l’implicazione delle specifiche tecniche rispetto agli standard industriali in evoluzione.

Come scegliere i componenti: compatibilità e interoperabilità

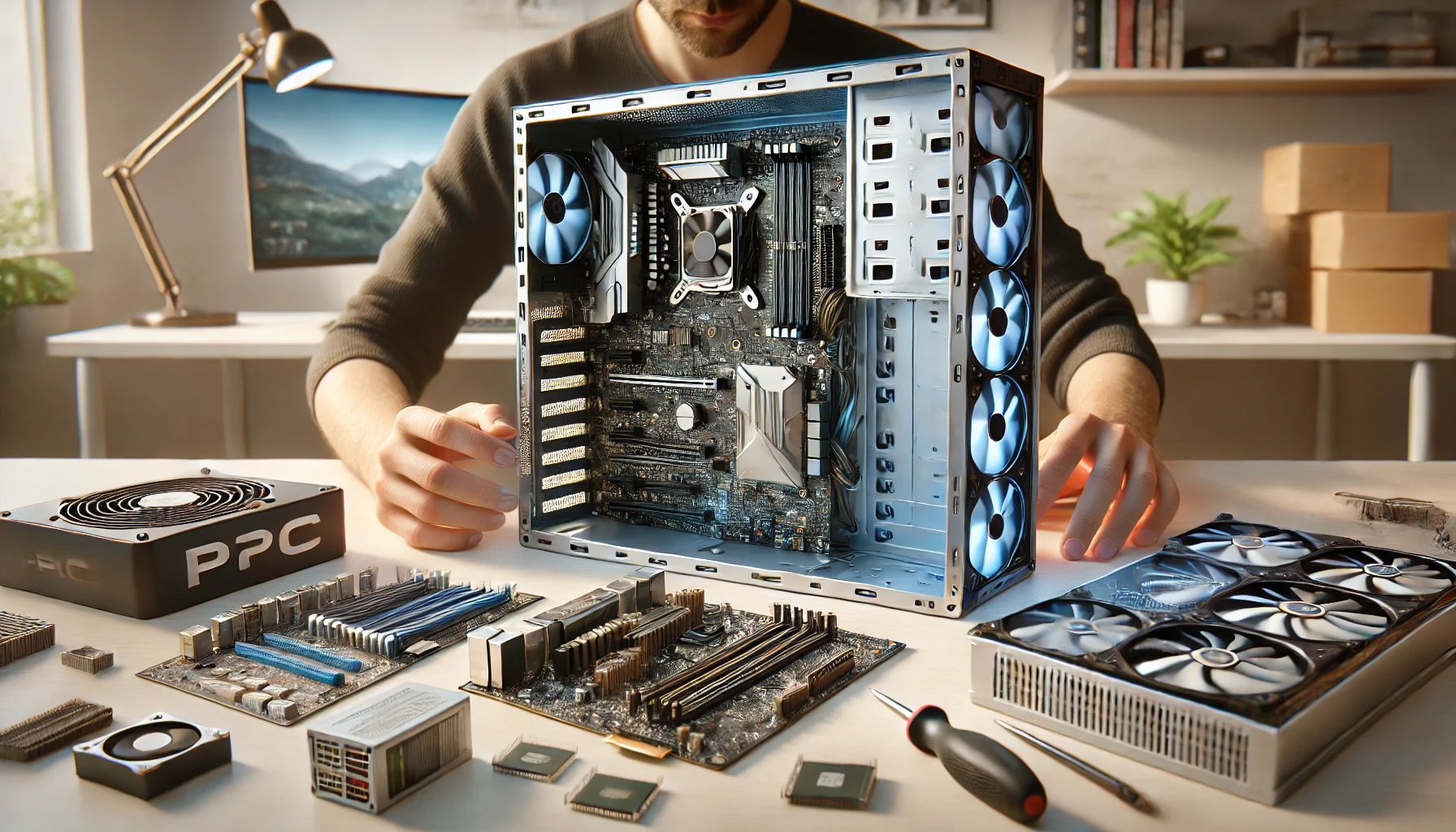

Il paradigma progettuale dell’assemblaggio si fonda sulla scelta sinergica di componenti primari: CPU, GPU, RAM, scheda madre, unità di archiviazione, PSU e chassis. La CPU costituisce il fulcro della computazione generale e vincola a monte la scelta del socket della motherboard, la quale, a sua volta, determina il tipo e la quantità massima di memoria volatile supportata, così come le specifiche dei bus di espansione.

Nel caso di configurazioni ad alte prestazioni, la selezione di una GPU dedicata non è solo funzionale al rendering grafico, ma può assolvere a compiti di computazione parallela mediante architetture GPGPU (General-Purpose Computing on Graphics Processing Units). Le unità di memoria, preferibilmente SSD NVMe in formato M.2, consentono latenze ridotte e velocità di trasferimento che superano di un ordine di grandezza i tradizionali dischi SATA.

La PSU, spesso sottovalutata, riveste invece un ruolo critico nella stabilità operativa del sistema: l’adozione di modelli con certificazione 80 Plus garantisce un’efficienza energetica superiore e una minore dissipazione termica. Il case deve offrire compatibilità con il formato della scheda madre (ATX, Micro-ATX, ITX) e un adeguato supporto per la ventilazione passiva e attiva, spesso mediante configurazioni a flusso d’aria diretto.

La fase di assemblaggio: metodologia e precauzioni

L’ambiente operativo deve essere concepito per minimizzare il rischio di scariche elettrostatiche, mediante l’uso di superfici antistatiche e, se disponibile, braccialetti ESD. L’assemblaggio inizia con l’installazione della CPU nel socket, un’operazione che richiede estrema precisione per evitare danni ai pin, seguita dalla distribuzione della pasta termoconduttiva e dal montaggio del sistema di dissipazione, che può essere ad aria o a liquido.

L’inserimento dei moduli RAM deve rispettare la configurazione a doppio canale, alternando gli slot secondo le istruzioni fornite dal produttore della motherboard. Successivamente, la scheda madre viene alloggiata nel case mediante l’allineamento con i distanziatori filettati, garantendo un isolamento fisico dai conduttori metallici dello chassis. La connessione delle linee di alimentazione, così come il posizionamento delle unità di storage e della GPU, devono seguire le specifiche tecniche dei connettori SATA, PCIe e ATX, e tenere conto del bilanciamento termico all’interno del sistema.

Un cablaggio ordinato, eventualmente supportato da canaline per il cable management, non è solo esteticamente apprezzabile, ma fondamentale per la gestione termica e l’ispezionabilità del sistema in fase di manutenzione.

Il post-assemblaggio: verifica funzionale e installazione software

Completata l’integrazione hardware, si procede con il primo avvio a pannello aperto per verificare l’esecuzione del POST (Power-On Self-Test). Eventuali segnali acustici o luminosi devono essere interpretati secondo la mappatura diagnostica del BIOS/UEFI. Se tutti i sottosistemi vengono correttamente rilevati, si accede al firmware per la configurazione delle priorità di boot, la gestione delle ventole e, se necessario, il flashing del BIOS con versioni aggiornate.

L’installazione del sistema operativo, tipicamente mediante supporto USB configurato con immagine ISO, deve avvenire dopo la corretta rilevazione delle unità di storage e, preferibilmente, in modalità UEFI con partizionamento GPT. Segue l’installazione dei driver, che possono essere scaricati dal sito ufficiale del produttore o gestiti tramite software di aggiornamento proprietario. L’ottimizzazione post-installazione può includere la disattivazione di processi in background non essenziali, la configurazione di profili energetici avanzati e, ove previsto, l’attivazione di tecnologie come XMP (eXtreme Memory Profile) per la RAM ad alte prestazioni.

La pratica dell’assemblaggio non esaurisce il suo valore nell’atto tecnico, ma si configura come esercizio epistemologico di esplorazione e comprensione del mezzo informatico. In un ecosistema sempre più orientato al consumo di dispositivi chiusi e opachi, il gesto di costruire un computer si pone in antitesi alla logica della black box, affermando una relazione critica, trasparente e partecipata con la tecnologia.

Le comunità online, in questo senso, non solo costituiscono un bacino inesauribile di sapere distribuito, ma rappresentano anche un laboratorio di sperimentazione orizzontale, in cui le pratiche di troubleshooting e ottimizzazione si arricchiscono continuamente grazie all’intelligenza collettiva. Piattaforme come PCPartPicker, Reddit (r/buildapc) o StackExchange non fungono solo da supporto, ma sono strumenti di apprendimento e validazione delle proprie competenze.

Costruire un PC da zero, nel contesto contemporaneo, assume un valore che va oltre la prestazione computazionale: è una forma di agency tecnologica. Significa reimpossessarsi delle infrastrutture digitali che mediano ogni aspetto della nostra vita, dalla produzione di contenuti alla formazione, dal lavoro alla socialità. Significa, in ultima analisi, accedere a un sapere materiale che emancipa l’utente dal ruolo di consumatore passivo, elevandolo a progettista del proprio ambiente computazionale. In quest’ottica, l’autoassemblaggio non è solo un atto tecnico, ma un gesto culturale e politico di riappropriazione della competenza digitale.